СТАТТІ

18:02, 4 грудня 2025 р.

Як Facebook використовують для поширення фейків: розбір механізмів та поради для мешканців Слов’янська

СТАТТІ

Дизайн: 6262

Слов’янськ уже понад десять років живе в умовах постійного інформаційного тиску. З 2014 року російська пропаганда цілеспрямовано атакує мешканців Донеччини — поширює панічні повідомлення, історії, що розпалюють ненависть, та маніпуляції, які мають підірвати довіру українців одне до одного. Усі пам’ятають славнозвісний фейк про хлопчика, якого ніби розіп’яли на головній площі Слов’янська. Але це був лише початок і з роками російська пропаганда лише посилює свої позиції в інформаційному просторі.

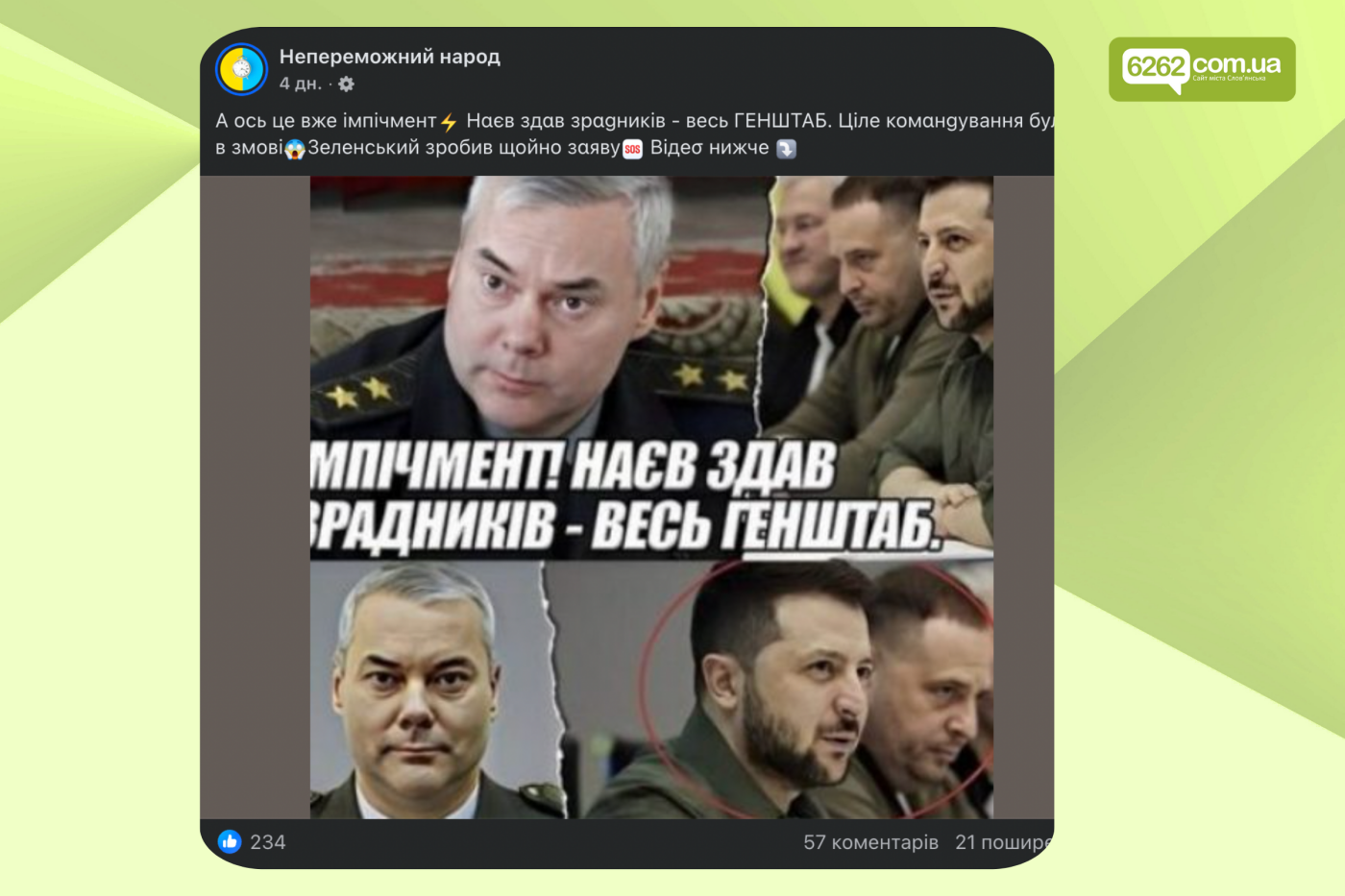

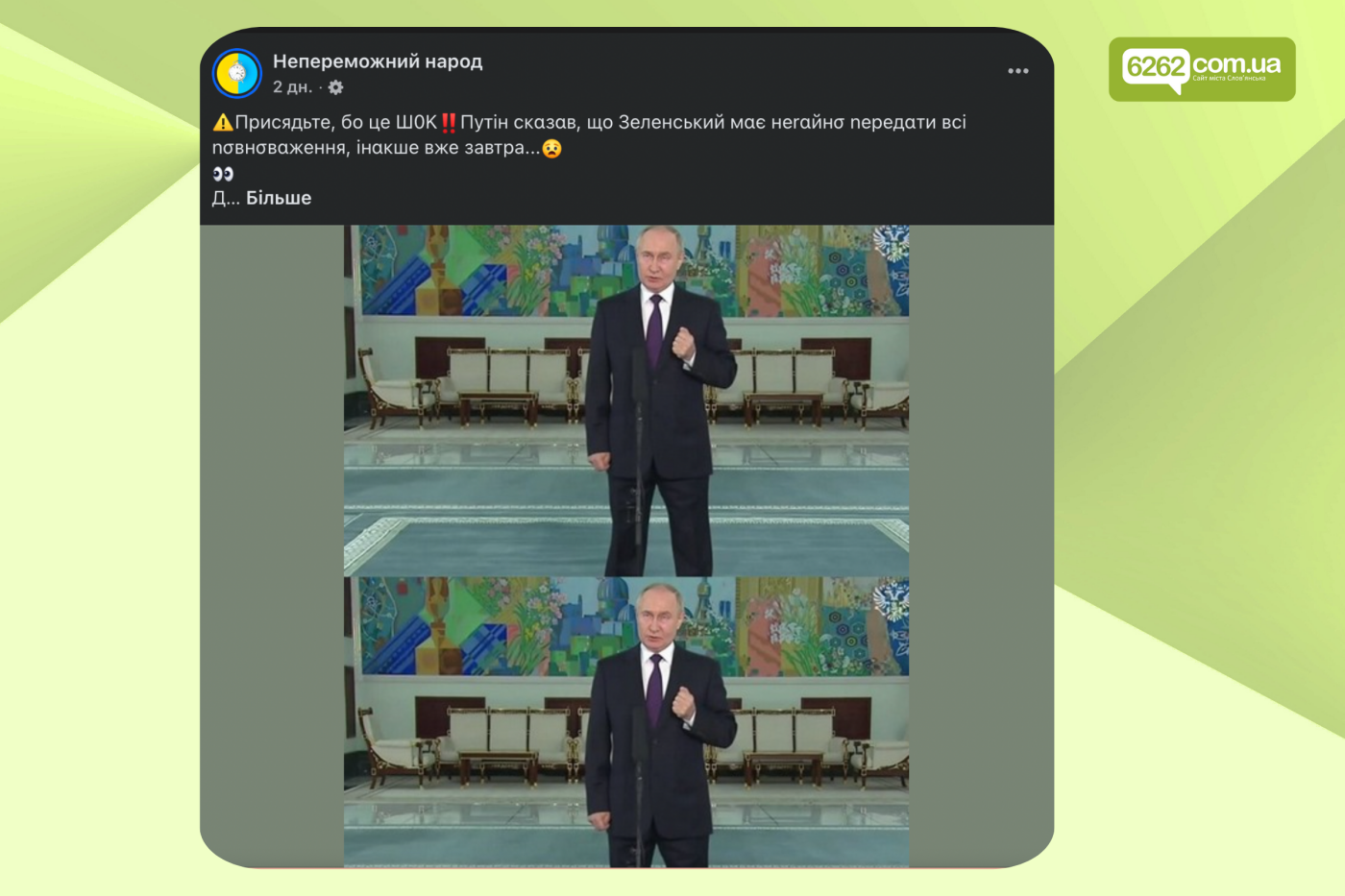

Сьогодні фейки — це вже не груба вигадка, а складні інформаційні операції, які використовують психологію, алгоритми та емоції. Особливо активно ці кампанії працюють у Facebook — одній із популярних соцмереж серед жителів міста. У цьому матеріалі розбираємо, як вони працюють, на кого спрямовані та як мешканці Слов’янська можуть убезпечити себе від фейків та маніпуляцій.

Facebook як майданчик для пропаганди в Україні

Facebook залишається платформою, де домінує текст, хоча фото та відео компонент відіграють значну роль. Тут легко розганяти «великі» емоційні історії — нібито реальні свідчення, життєві ситуації, «сповіді» та дописи, що апелюють до співчуття чи обурення. Саме тому ця соцмережа стала зручною мішенню для маніпуляторів.

За словами фактчекерки, медіатренерки та співзасновниці платформи StopFake Ольги Юркової, багато таких дописів спеціально створюють так, щоб викликати сильні емоції. У них часто закладені меседжі російської пропаганди — але подані у формі начебто особистих історій.

Найбільше фейки спрямовані на людей середнього та старшого віку — тих, хто споживає новини саме через Facebook і звик довіряти знайомим групам або активним коментаторам. Такі користувачі часто не помічають, як пропаганда працює через фейкові акаунти, ботоферми або сторінки, що тривалий час видавали себе за звичайні спільноти.

Окремо варто згадати алгоритми Facebook: платформа реагує на активність. Реакція, будь-який коментар, навіть «фейк» чи «брехня», підсилює допис і збільшує його охоплення. Це робить маніпуляції ще ефективнішими. Звісно, існують важелі впливу та перевірка, проте вони не завжди вчасно і досконало спрацьовують.

“Російські спецслужби організовують масштабні ботоферми, що запускають інформаційні кампанії на різних платформах одночасно. Вони працюють не лише з ідеологічною метою — тут є і бізнес-модель. Клікбейт генерує прибуток. Існують приклади, коли македонські ботоферми заробляли на американській політиці через рекламу, вірменські мережі працювали на Україну, Росію та США одночасно, а мережі легко перемикалися між ринками залежно від вигоди. Люди поширюють, алгоритми підсилюють, а ботоферми отримують прибуток”, - розповідає фактчекерка.

Дезінформація у Facebook найбільше впливає через емоції, використовуючи принцип «гойдалок»: людину постійно переводять із страху в розпач, із розпачу в гнів, а з гніву — у співчуття. У такому стані критичне мислення слабшає, і люди охочіше поширюють фейки.

Ольга розповідає, що фейки в Україні розвивалися хвилями. У 2022 році домінували страх та паніка: чутки про нічні обстріли, фейкові захоплення районів, отруєну воду та масові історії про «мітки корегувальників».

У 2022–2023 роках розпалювали сварки між українцями, поширюючи легенди про «поганих переселенців» і «підпали орендованих квартир», причому жодного з цих випадків поліція не підтвердила.

У 2024 році ж основні зусилля спрямували на антимобілізаційні меседжі: про те, що «мобілізують більше на сході», що «переселенці сидять у кафе», «бусифікацію», а також на кампанії проти ЗСУ, влади та волонтерів. Мета цих фейків — посіяти недовіру та зламати суспільство зсередини.

Facebook-групи та алгоритми створюють ідеальні умови для впливу

Групи стали одним із найуразливіших інструментів для маніпуляцій у Facebook. На перший погляд, групи створюють відчуття спільноти — місця, де люди об’єднані спільними інтересами, географією або досвідом. Саме ця видима «близькість» формує довіру: користувачі схильні сприймати інформацію в групах як більш правдиву, ніж у публічних сторінках чи новинних стрічках. Проте маніпулятори давно навчилися використовувати цей механізм. Вони створюють чи скуповують уже розкручені групи й поступово починають просувати у них політизований або дезінформаційний контент, який аудиторія сприймає без належної критики.

Інформаційні бульбашки, які формуються довкола таких груп, створюють ілюзію консенсусу: користувачеві здається, що всі навколо поділяють певну думку, бо алгоритм підсовує йому дедалі більше контенту того ж типу. Будь-яка альтернативна позиція або зважений аналіз залишаються поза його інформаційним полем. Це робить людей більш вразливими до токсичних наративів, формує недовіру до офіційних джерел і підсилює поляризацію всередині суспільства.

Зрештою, Facebook-групи, які мали б працювати як інструмент об’єднання, стають середовищем контрольованої дестабілізації. Саме в них найчастіше запускаються хвилі чуток, організовуються скоординовані інформаційні атаки та «підігріваються» локальні конфлікти. Алгоритмічне підсилення таких матеріалів перетворює одну маніпуляцію на лавину, яка охоплює тисячі людей

Нова реальність інформаційних атак

Сучасна пропаганда увійшла в нову фазу, у якій штучний інтелект, автоматизовані мережі та професійні ботоферми створюють небачений раніше масштаб маніпуляцій, що поєднують психологічний тиск, алгоритмічне підсилення та технологічно досконалі фейки.

Експертка зі штучного інтелекту Юлія Машута розповідає, що ШІ змінив правила в інформаційних операціях за трьома параметрами: швидкість, вартість і варіативність. Контент тепер генерується миттєво, коштує копійки та може мати необмежену кількість унікальних версій. ШІ дає можливість створювати десятки тисяч коментарів, моделювати «живі» акаунти, персоналізувати наративи та знімати реалістичні фейкові відео.

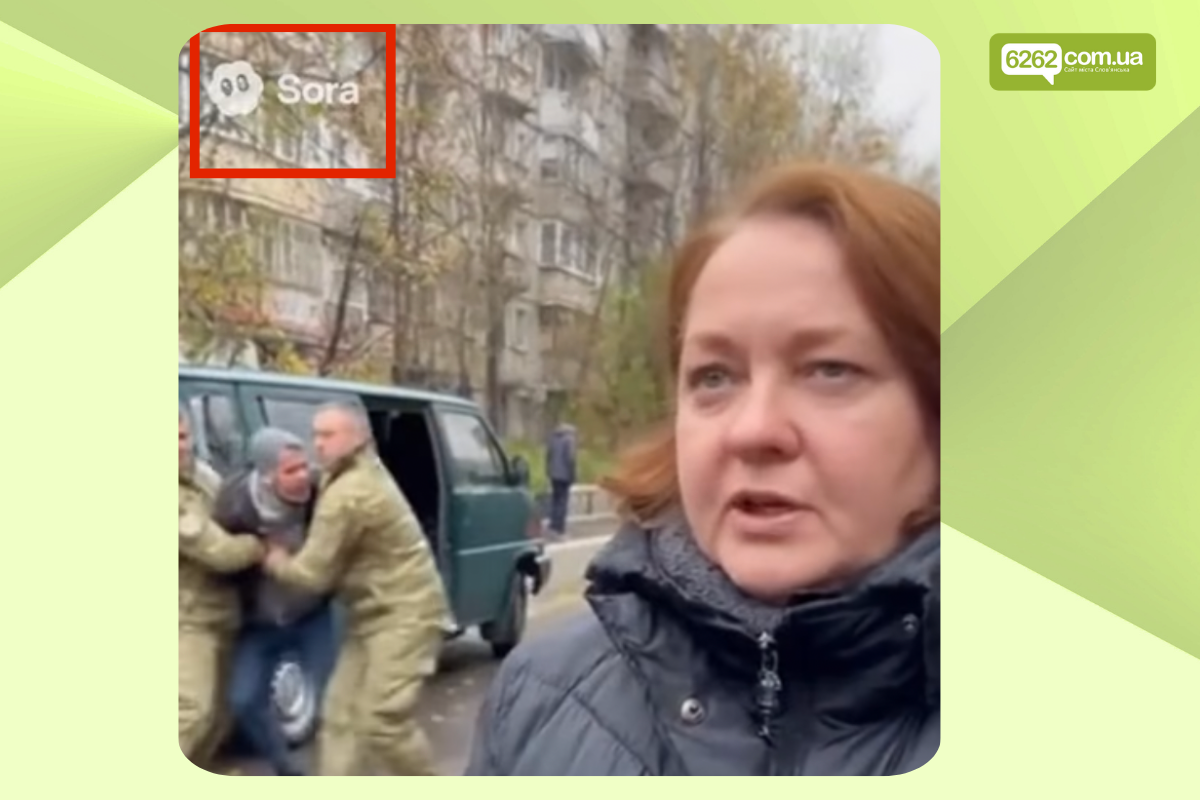

Одним із прикладів цього явища, зокрема, є відео, створені за допомогою генеративних систем на кшталт Sora, фейкові фото, зокрема з війни, AI-генеровані голоси.

Як приклад - відео у Facebook, де жінка говорить, що ніякої примусової мобілізації в Україні немає, тоді як позаду неї військові тягнуть чоловіка до “бусика”. Попри те, що на відео був водяний знак Sora (ознака генерації ШІ), багато користувачів соцмереж сприйняли його за реальне. Підживили цей фейк і коментарі під відео, які висловлювали гнів та обурення ситуацією. Частина з них була залишена підозрілими акаунтами, що може свідчити про їх фейковість.

Ці приклади демонструють, що фейки сьогодні не є просто текстом чи зображенням — це складні емоційні конструкції, які використовують технології нового покоління для збудження гніву, страху та недовіри.

Як перевіряти інформацію у Фейсбук

За словами Ольги Юркової, Meta у 2024 році закрила низку інструментів для дослідників, зокрема CrowdTangle (CrowdTangle був інструментом для аналізу соціальних мереж, який дозволяв досліджувати загальнодоступний контент на платформах, таких як Facebook та Instagram), тому сьогодні головна роль у боротьбі з фейками у Facebook лягає на незалежних фактчекерів та самих користувачів.

Алгоритм перевірки інформації у Facebook включає декілька кроків:

Спершу варто зупинитися й оцінити власну емоційну реакцію, адже сильні емоції — частий індикатор маніпуляції.

Далі слід перевірити акаунт автора: чи має він реальні фото, друзів, теги від інших користувачів і чи не виглядає як бот.

У тексті важливо звертати увагу на конкретику, тригерні слова та орфографічні помилки, які часто використовуються для обходу алгоритмів.

Фото й відео потрібно перевіряти окремо, зважаючи й на типові ознаки контенту, створеного штучним інтелектом — неприродні руки, спотворення, надлишкові деталі.

Після цього варто пошукати інформацію в медіа з «білого списку» або у офіційних каналах.

Останній крок — оцінити мотив: кому вигідно, щоб ви повірили в цей контент, і що він намагається викликати.

Якщо допис виявився фейком, на нього слід поскаржитися та за можливості надіслати фактчекерам, але ні в якому разі не поширювати — навіть із поміткою «це фейк».

Для аналізу фото та відео можна звернути увагу на деталі, які свідчать про генерацію:

Неприродні тіні та відбиття

Розмиті або дивні деталі

Аномалії на руках (6 пальців)

Незбіг шрифтів на табличках

Надто "ідеальні" обличчя

Розмиті фони з артефактами

Незвичне освітлення

Для перевірки також можна використовувати Google, Google Images, TinEye та Bing Visual Search, які дозволяють знайти зворотні збіги зображень.

InVID/WeVerify допомагає аналізувати відео, а Wayback Machine — переглядати архівні версії сайтів. Також можна звернутись до незалежних фактчекерів, аби вони перевірили інформацію.

Можна також звернутись до фактчекерів, які спеціалізуються на перевірці інформації. В Україні це StopFake.org, VoxCheck, бот Перевірка. На державному рівні працює Центр протидії дезінформації, Центр стратегічних комунцкацій.

Перевірка інформації за допомогою ШІ

Юлія Машута зазначає, що сучасні моделі штучного інтелекту, зокрема ChatGPT або Gemini, можуть допомагати у перевірці сумнівного контенту, але лише за умови правильного запиту. Варто звертатися до них у форматі: «Перевір цю інформацію як фактчекер: наведи джерела, контекст і чи є ознаки маніпуляції», — це дає змогу отримати точнішу та обґрунтованішу відповідь.

Експертка з ШІ радить перевіряти достовірності Facebook-поста за наступним промптом:

Ти — асистент-фактчекер. Мета: перевірити достовірність Facebook-поста (текст + зображення) й пояснити результат звичайному читачу. Працюй українською, нейтрально, без емоційних оцінок. Використовуй веб-пошук там, де це потрібно. Якщо даних немає — познач «немає даних».

Вхідні дані:

Текст поста (повністю):""" [ВСТАВ ТЕКСТ ПОСТА] """

Посилання на пост або скриншот (якщо є):[Встав посилання]

Картинка/опис зображення (якщо модель не бачить файлу, опиши текстом, що там зображено):""" [Опиши, що видно на картинці: люди/місце/текст/логотипи/дата тощо] """

КРОК 1 — Виділення тверджень

Випиши з тексту поста всі окремі фактологічні твердження нумерованим списком (1–10+ пунктів). Кожне твердження — одне чітке просте речення.

Для кожного твердження вкажи тип:

[факт]

[прогноз]

[оціночне судження]

[маніпулятивне формулювання]

Для тверджень типу [факт] додай статус: «статус перед перевіркою: потребує перевірки».

КРОК 2 — План пошуку

Для кожного твердження типу [факт]:

Сформулюй 1–2 запити для веб-пошуку (ключові слова, місце, дата, прізвища, якщо є).

Вкажи рекомендовані джерела за пріоритетом:

рівень A: офіційні сайти урядових/муніципальних органів, ВООЗ, ООН, офіційна статистика, судові реєстри;

рівень B: наукові публікації, звіти авторитетних організацій, офіційні блоги/заяви компаній (Meta/Facebook тощо);

рівень C: фактчекінгові медіа (StopFake, VoxCheck, Reuters Fact Check, AFP Fact Check, Snopes, PolitiFact тощо), якісні медіа.

Покажи «План пошуку» у вигляді списку: № твердження → запит → джерела A/B/C.

КРОК 3 — Перевірка тверджень (з веб-пошуком)

Послідовно перевір кожне твердження типу [факт], використовуючи веб-пошук.

Створи таблицю:

№ твердження

Короткий переформульований факт

Джерела (1–3 посилання)

Коротка цитата або суть (1–2 речення)

Результат перевірки: [підтверджено] / [спростовано] / [частково] / [немає даних]

Примітка (що важливо знати: дати, методологія, можливі винятки)

Не посилайся на анонімні або сумнівні джерела як на основні.

КРОК 4 — Аналіз зображення / візуалу

Навіть якщо ти не бачиш картинку напряму, працюй з тим, що є у вхідних даних:

Опиши, яке враження має створювати зображення і як воно пов’язане з текстом (підсилює, відволікає, маніпулює контекстом).

Якщо є можливість проаналізувати файл — оціни:

чи є на зображенні явні ознаки монтажу / невідповідності (спотворені об’єкти, текст, тіні тощо);

чи відповідає картинка заявленому місцю/часу/події (якщо вказані в тексті).

Якщо ти не бачиш файл, опиши які кроки треба зробити людині для перевірки картинки:

reverse image search (Google Images, TinEye, Yandex, інші);

пошук оригіналу фото;

перевірка дати публікації

пошук того ж сюжету в медіа / офіційних джерелах.

Чітко познач, де ти робиш реальний аналіз, а де — даєш рекомендації до дій користувача.

КРОК 5 — Висновок для читача

Сформулюй підсумок у 3–6 реченнях:

що в пості підтвердилося;

що виявилось неправдою або маніпуляцією;

де бракує достатніх даних.

Додай список «червоних прапорців» саме цього поста (3–7 пунктів): емоційні формулювання, заклики «терміново поширити», відсутність джерел, дуже точні «секретні» подробиці тощо.

Дай рекомендацію користувачу у 1–2 реченнях: наприклад, «не варто поширювати цей пост, бо ключові твердження спростовані/непідтверджені» або «цей пост загалом відповідає фактам, але варто зважати на…».

Форматуй відповідь у блоки:

Твердження з поста

План пошуку

Таблиця перевірки

Аналіз зображення

Висновок для читача

Кожен фейк - це не випадковість

Досвід останніх років показує: інформаційні атаки йдуть поряд із війною. Фейки, маніпуляції, ботоферми та штучний інтелект працюють не хаотично, а за продуманими схемами, націленими насамперед на емоції людей. Вони розкручують страх, гнів, недовіру, ворожнечу між регіонами та групами населення — саме на цих емоціях будуються найбільш успішні дезінформаційні кампанії.

Кожен фейк — це не випадковість, а чиясь цілеспрямована дія. Російські спецслужби, шахраї, політичні маніпулятори та ботоферми використовують соціальні мережі, щоб впливати на настрої, деморалізувати суспільство й послабити українську стійкість. Але водночас презентації, інструкції та приклади демонструють і інше — ми можемо ефективно цьому протистояти.

Головне — уповільнитись. Не реагувати автоматично. Перевіряти джерело, шукати факти, аналізувати контекст, розуміти, як працюють алгоритми та чому саме ви бачите той чи інший допис. Бо сила дезінформації — у нашій необдуманій реакції, а сила правди — у нашій здатності зупинитися та перевірити.

Слов’янськ, як і вся Донеччина, роками живе під подвійним тиском — війни та пропаганди. Але саме тому медіаграмотність тут стає не просто корисною навичкою, а частиною безпеки. Коли ми знаємо, як працюють інформаційні атаки, вони перестають бути невидимою зброєю. А суспільство, яке розуміє механізми маніпуляцій і не піддається їм, стає сильнішим — навіть у найближчому до фронту місті.

Якщо ви помітили помилку, виділіть необхідний текст і натисніть Ctrl + Enter, щоб повідомити про це редакцію

Останні новини

18:21

Вчора

17:22

Вчора

16:40

Вчора

16:01

Вчора

13:22

Вчора

Спецтема

Оголошення

12:02, 9 березня

12:02, 9 березня

12:02, 9 березня

12:02, 9 березня

12:02, 9 березня

Коментарі